POML:结构化提示工程的兴起与AI应用架构的“新三驾马车”展望

引言

在人工智能(AI)飞速发展的今天,提示工程(Prompt Engineering)正从一门依赖直觉的“艺术”转型为系统化的“工程”实践。微软于2025年推出的POML(Prompt Orchestration Markup Language)作为一种结构化标记语言,为这一变革注入了新动力。POML不仅解决了传统提示工程的混乱与低效,还预示着AI应用架构可能迎来类似Web开发的“HTML/CSS/JS三驾马车”范式。本文基于一份深入研究报告,详细剖析POML的核心技术、与Web架构的类比、实际应用场景以及未来潜力,为开发者与企业提供可操作的洞见。

POML开启提示工程新纪元

POML由微软研究院推出,其设计灵感源自HTML和XML,旨在通过模块化、语义化的标签(如<role>、<task>)将复杂的提示分解为清晰的组件,解决传统“提示意面”(Prompt Spaghetti)的痛点。它通过以下特性重塑提示工程:

- 语义化标签:提升提示的可读性、可维护性和可重用性。

- 多模态支持:无缝整合文本、表格、图像等数据。

- 样式系统:受CSS启发,分离内容与呈现,简化A/B测试。

- 动态模板:支持变量、循环和条件,实现自动化和个性化。

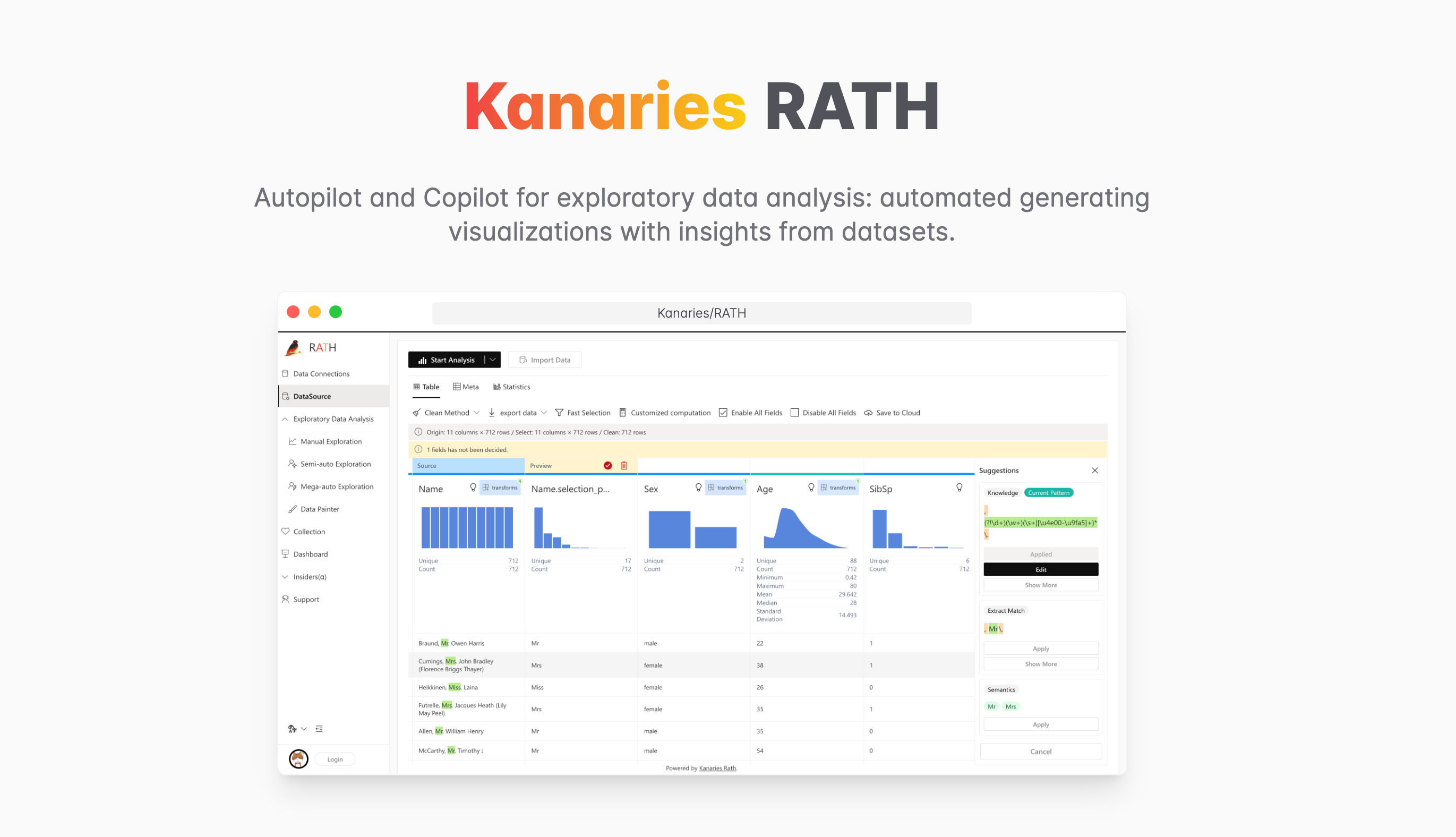

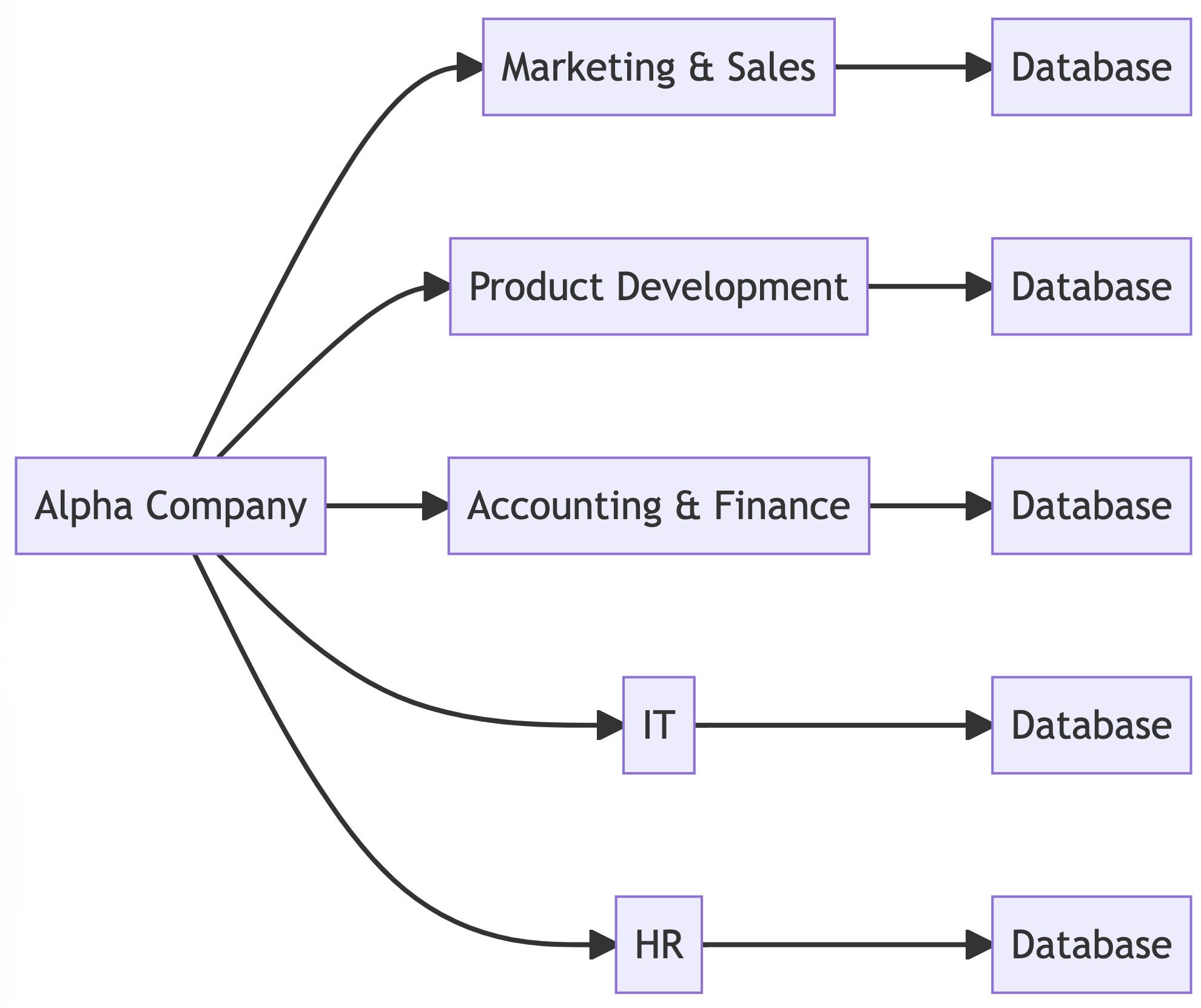

POML不仅是一门语言,更是AI应用架构的结构层,与优化工具(如PromptPerfect)和编排框架(如LangChain)共同构成“新三驾马车”。这一架构与学术界提出的“提示分层架构”(Prompt-Layered Architecture, PLA)理论高度契合,将提示管理提升为与传统软件开发同等重要的“第一公民”。

未来,POML有望成为多智能体系统(Multi-Agent Systems)的“通信协议”和“配置语言”,为构建可扩展、可审计的AI应用奠定基础。尽管社区对其复杂性存在争议,但其潜力不可忽视。本文将为开发者提供实用建议,助力企业拥抱这一变革。